Diferencia entre la desviación estándar y el error estándar

- 2878

- 95

- Rubén Alarcón

Desviación Estándar se define como una medida absoluta de dispersión de una serie. Aclara la cantidad estándar de variación a cada lado de la media. A menudo se malinterpretan con el error estándar, ya que se basa en la desviación estándar y el tamaño de la muestra.

Desviación Estándar se define como una medida absoluta de dispersión de una serie. Aclara la cantidad estándar de variación a cada lado de la media. A menudo se malinterpretan con el error estándar, ya que se basa en la desviación estándar y el tamaño de la muestra.

Error estándar se usa para medir la precisión estadística de una estimación. Se utiliza principalmente en el proceso de prueba de hipótesis y intervalo de estimación.

Estos son dos conceptos importantes de estadísticas, que se utilizan ampliamente en el campo de la investigación. La diferencia entre la desviación estándar y el error estándar se basa en la diferencia entre la descripción de los datos y su inferencia.

Contenido: desviación estándar vs error estándar

- Cuadro comparativo

- Definición

- Diferencias clave

- Conclusión

Cuadro comparativo

| Base para la comparación | Desviación Estándar | Error estándar |

|---|---|---|

| Significado | La desviación estándar implica una medida de dispersión del conjunto de valores de su media. | El error estándar connota la medida de la exactitud estadística de una estimación. |

| Estadística | Descriptivo | Inferencial |

| Medidas | ¿Cuántas observaciones varían entre sí?. | Cuán precisa la media de la muestra para la verdadera población media. |

| Distribución | Distribución de la observación con respecto a la curva normal. | Distribución de una estimación sobre la curva normal. |

| Fórmula | Raíz cuadrada de varianza | Desviación estándar dividida por la raíz cuadrada del tamaño de la muestra. |

| Aumento del tamaño de la muestra | Da una medida más específica de la desviación estándar. | Disminuye el error estándar. |

Definición de desviación estándar

Desviación estándar, es una medida de la propagación de una serie o la distancia desde el estándar. En 1893, Karl Pearson acuñó la noción de desviación estándar, que sin duda es la medida más utilizada, en estudios de investigación.

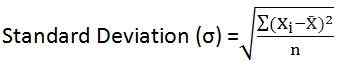

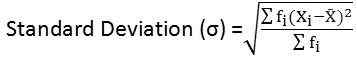

Es la raíz cuadrada del promedio de cuadrados de desviaciones de su media. En otras palabras, para un conjunto de datos determinado, la desviación estándar es la deviación cuadrada de raíz, de la media aritmética. Para toda la población, se indica por la letra griega 'Sigma (σ)', y para una muestra, está representada por la letra latina 's' s 's'.

La desviación estándar es una medida que cuantifica el grado de dispersión del conjunto de observaciones. Cuanto más lejos sean los puntos de datos del valor medio, mayor es la desviación dentro del conjunto de datos, lo que representa que los puntos de datos están dispersos en un rango más amplio de valores y viceversa.

- Para datos no clasificados:

- Para la distribución de frecuencia agrupada:

Definición de error estándar

Es posible que haya observado que diferentes muestras, con un tamaño idéntico, extraído de la misma población, darán diversos valores de estadística en consideración, i.mi. muestra promedio. Error estándar (SE) proporciona la desviación estándar en diferentes valores de la media de muestra. Se utiliza para hacer una comparación entre las medias de muestra en las poblaciones.

En resumen, el error estándar de una estadística no es más que la desviación estándar de su distribución de muestreo. Tiene un gran papel para jugar las pruebas de hipótesis estadística y estimación de intervalos. Da una idea de la exactitud y confiabilidad de la estimación. Cuanto más pequeño sea el error estándar, mayor es la uniformidad de la distribución teórica y viceversa.

- Fórmula: Error estándar para la media de muestra = σ/√n

Donde, σ es la desviación estándar de la población

Diferencias clave entre la desviación estándar y el error estándar

Los puntos establecidos a continuación son sustanciales en lo que respecta a la diferencia entre la desviación estándar:

- La desviación estándar es la medida que evalúa la cantidad de variación en el conjunto de observaciones. Error estándar mide la precisión de una estimación, yo.mi. Es la medida de variabilidad de la distribución teórica de una estadística.

- La desviación estándar es una estadística descriptiva, mientras que el error estándar es una estadística inferencial.

- La desviación estándar mide cuán lejos están los valores individuales del valor medio. Por el contrario, cuán cerca está la media de la muestra para la población media.

- La desviación estándar es la distribución de observaciones con referencia a la curva normal. Con respecto a esto, el error estándar es la distribución de una estimación con referencia a la curva normal.

- La desviación estándar se define como la raíz cuadrada de la varianza. Por el contrario, el error estándar se describe como la desviación estándar dividida por la raíz cuadrada del tamaño de la muestra.

- Cuando se eleva el tamaño de la muestra, proporciona una medida más particular de la desviación estándar. A diferencia del error estándar cuando se aumenta el tamaño de la muestra, el error estándar tiende a disminuir.

Conclusión

En general, la desviación estándar se considera una de las mejores medidas de dispersión, lo que mide la dispersión de valores del valor central. Por otro lado, el error estándar se usa principalmente para verificar la confiabilidad y precisión de la estimación y, por lo tanto, cuanto menor sea el error, mayor es su confiabilidad y precisión.