Diferencia entre MapReduce y Spark

- 3988

- 606

- Miguel Arias

Apache Spark es uno de los proyectos de código abierto más activos en el ecosistema de Hadoop y una de las tecnologías más populares en el análisis de Big Data hoy en día. Tanto MapReduce como Spark son marcos de código abierto para el procesamiento de big data. Sin embargo, Spark es conocido por el procesamiento en memoria y es ideal para casos en los que los datos se ajustan en la memoria, particularmente en grupos dedicados. Comparamos los dos marcos de software líderes para ayudarlo a decidir cuál es el adecuado para usted.

¿Qué es Hadoop MapReduce??

MapReduce es un modelo de programación dentro del marco Hadoop para la computación distribuida basada en Java. Se utiliza para acceder a Big Data en el sistema de archivos Hadoop (HDFS). Es una forma de estructurar su cálculo que le permite ejecutar fácilmente en muchas máquinas. Permite una escalabilidad masiva en cientos o miles de servidores en un clúster de Hadoop. Permite escribir trabajos distribuidos y escalables con poco esfuerzo. Sirve dos funciones esenciales: filtra y distribuye trabajo a varios nodos dentro del clúster o mapa. Se utiliza para el análisis de datos a gran escala utilizando múltiples máquinas en el clúster. Un marco de MapReduce es típicamente un proceso de tres pasos: mapa, baraja y reduzca.

¿Qué es Apache Spark??

Spark es un marco de Big Data de código abierto, super rápido, considerado ampliamente el sucesor del marco MapReduce para procesar grandes datos. Spark es una mejora de Hadoop para MapReduce utilizada para las cargas de trabajo de Big Data. Para una organización que tiene grandes cantidades de datos para analizar, Spark ofrece una forma rápida y fácil de analizar esos datos en un clúster completo de computadoras. Es un motor de análisis unificado de varios idiomas para big data y aprendizaje automático. Su modelo de programación unificado lo convierte en la mejor opción para los desarrolladores que crean aplicaciones analíticas ricas en datos. Comenzó en 2009 como un proyecto de investigación en Amplab de UC Berkley, un esfuerzo de colaboración que involucra a estudiantes, investigadores y profesores.

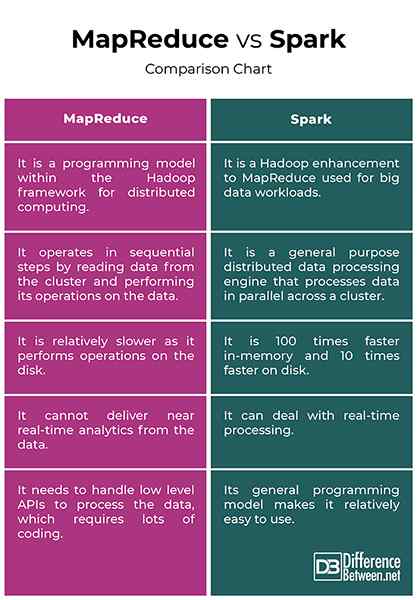

Diferencia entre MapReduce y Spark

Procesamiento de datos

- Hadoop procesa datos en lotes y MapReduce opera en pasos secuenciales leyendo datos del clúster y realizando sus operaciones en los datos. Los resultados se vuelven a escribir al clúster. Es una forma efectiva de procesar conjuntos de datos estáticos grandes. Spark, por otro lado, es un motor de procesamiento de datos distribuido de propósito general que procesa los datos en paralelo en un clúster. Realiza el procesamiento de datos en tiempo real y gráficos.

Actuación

- Hadoop MapReduce es relativamente más lento, ya que realiza operaciones en el disco y no puede entregar análisis cercanos a tiempo real desde los datos. Spark, por otro lado, está diseñado de tal manera que transforma los datos en memoria y no en el disco de E/S, lo que a su vez reduce el tiempo de procesamiento. Spark es en realidad 100 veces más rápido en memoria y 10 veces más rápido en el disco. A diferencia de MapReduce, puede tratar con el procesamiento en tiempo real.

Costo

- Hadoop funciona a un costo menor, ya que es un software de código abierto y requiere más memoria en el disco, que es relativamente un producto económico. Spark requiere más RAM, lo que significa que configurar clústeres de chispa puede ser más caro. Además, Spark es relativamente nuevo, por lo que los expertos en Spark son hallazgos raros y más costosos.

Tolerancia a fallos

- MapReduce está estrictamente basado en el disco significa que utiliza el almacenamiento persistente. Si bien ambos proporcionan cierto nivel de fallas de manejo, la tolerancia de fallas de Spark se basa principalmente en sus operaciones RDD (datos de datos distribuidos resilientes). RDD es el bloque de construcción de Apache Spark. Hadoop es naturalmente tolerante a fallas porque está diseñado para replicar datos en varios nodos.

Facilidad de uso

- MapReduce no tiene un modo interactivo y es bastante complejo. Debe manejar las API de bajo nivel para procesar los datos, lo que requiere mucha codificación, y la codificación requiere conocimiento de las estructuras de datos involucradas. Spark está diseñado de abajo hacia arriba para el rendimiento y la facilidad de uso, que proviene de su modelo de programación general. Además, los programas paralelos se parecen mucho a los programas secuenciales, lo que los hace más fáciles de desarrollar.

MapReduce vs. Spark: tabla de comparación

Resumen

La principal diferencia entre los dos marcos es que MapReduce procesa datos en el disco, mientras que Spark procesa y retiene los datos en la memoria para los pasos posteriores. Como resultado, Spark es 100 veces más rápido en memoria y 10 veces más rápido en el disco que MapReduce. Hadoop utiliza la MapReduce para procesar datos, mientras que Spark usa conjuntos de datos distribuidos resilientes (RDDS). Spark es una mejora de Hadoop de MapReduce para procesar grandes datos. Si bien MapReduce todavía se usa para el análisis de datos a gran escala, Spark se ha convertido en el marco de procesamiento de referencia en entornos de Hadoop.

Por qué Spark es más rápido que MapReduce?

Spark procesa y retiene los datos en la memoria para pasos posteriores, lo que lo hace 100 veces más rápido para los datos en RAM y hasta 10 veces más rápido para los datos de almacenamiento. Sus RDDS habilitan múltiples operaciones de mapa en la memoria, mientras que MapReduce tiene que escribir resultados intermedios en un disco.

¿Cuáles son las diferencias entre el nombre de Spark y MapReduce al menos dos puntos??

Primero, MapReduce no puede entregar análisis casi en tiempo real desde los datos, mientras que Spark puede lidiar con el procesamiento de datos en tiempo real en tiempo real. Y segundo, MapReduce funciona en pasos secuenciales, mientras que Spark procesa los datos en paralelo en un clúster.

Es chispa más avanzada que mapreduce?

Spark es ampliamente considerado el sucesor del marco MapReduce para procesar grandes datos. De hecho, Spark es uno de los proyectos de código abierto más activos en el ecosistema de Hadoop y una de las tecnologías más populares en el análisis de Big Data hoy en día.

¿Spark necesita MapReduce??

Spark no usa ni necesita MapReduce, sino solo la idea de ella y no la implementación exacta.

- « Diferencia entre el sesgo de aprendizaje automático y la varianza

- Diferencia entre mascacio y plataforma fraccional »